코딩 에이전트 비교로 정리한 공통점 5가지와 에이전트 모드의 의미, 속도/컨텍스트/안정성 평가법, 권한·비용 리스크, 스타트업/엔터프라이즈 도입 기준, 30일 PoC 플랜을 소개해요.

코딩 에이전트 비교를 해보면, 결국 “자동완성”이 아니라 “작업 단위 실행”으로 넘어가는 AI 개발 도구 트렌드가 또렷하게 보여요. 이 글에서는 2026년 코딩 에이전트 15종을 비교할 때 공통으로 튀어나오는 5가지 포인트를 도입 체크포인트 관점에서 정리해드릴게요.

1) 에이전트형 vs 자동완성형 차이 (헷갈리면 여기서 결정나요)

자동완성형은 커서 근처의 문맥을 보고 다음 코드를 “제안”해주는 도구에 가까워요. 반면 에이전트형은 목표를 주면 계획을 세우고, 여러 파일을 바꾸고, 실행·검증까지 반복하면서 결과물을 “완료” 쪽으로 밀어붙이는 성격이 강해요.

실무에서 제가 제일 많이 보는 실패 패턴은, 팀이 자동완성형을 도입한다고 생각해놓고 실제로는 에이전트형을 켜버려서(또는 반대로) 권한/비용/리뷰 프로세스가 꼬이는 경우예요. 그래서 첫 미팅에서 딱 두 가지만 합의해요: “이 도구는 어디까지 자동으로 실행해도 되나요?” 그리고 “결과물은 PR로만 받나요, 로컬 변경도 허용하나요?”

- 자동완성형이 잘 맞는 일: 반복적인 코드 작성, 보일러플레이트, 작은 함수 구현, IDE 안에서 빠른 타이핑 보조

- 에이전트형이 잘 맞는 일: 멀티파일 리팩토링, 테스트 추가/수정, 버그 원인 추적 후 패치, 작은 기능을 ‘끝까지’ 완성하는 작업 흐름

여기서 자주 나오는 질문이 “에이전트 모드란?”인데요, 한 문장으로는 ‘목표 지향으로 계획→수정→실행→검증을 묶어 돌리는 모드’라고 보시면 돼요.

- 관련 링크: GitHub Blog “Agent mode 101” (에이전트 모드 개념을 잡기 좋아요).이 섹션만 명확해져도, 개발팀 도입 기준을 절반은 세운 거나 다름없어요.

https://github.blog/ai-and-ml/github-copilot/agent-mode-101-all-about-github-copilots-powerful-mode/

2) 2026년 코딩 에이전트 15종 비교에서 공통점 5가지(도입 체크포인트)

툴 이름이 뭐든(IDE 기반이든, CLI 기반이든) 2026년 코딩 에이전트 비교를 하면 비슷한 결론으로 수렴하는 지점이 있어요.

저는 이 5가지를 “도입 체크포인트”로 체크하면서 PoC를 설계해요.

공통점 1. 파일 단위가 아니라 ‘리포지토리 단위’ 컨텍스트로 간다

상위권 도구들은 한 파일만 보는 게 아니라, 리포 구조와 연관 파일을 같이 읽는 흐름이 기본이 되고 있어요. 그래서 “이 함수 고쳐줘”보다 “이 기능 흐름에서 깨지는 지점 찾아서 고쳐줘” 같은 요청이 가능해져요.

공통점 2. 빨리 답하는 것보다 ‘반복 수행 안정성’이 중요해진다

요즘은 응답 속도보다, 실패했을 때 스스로 재시도하고 테스트로 확인하는 루프가 더 큰 가치가 돼요. 팀 입장에서는 “한 번에 80점”보다 “세 번 시켜도 평균 75점”이 더 생산적이거든요.

공통점 3. 에이전트 모드가 별도 워크플로로 분리된다

에이전트 모드는 보통 채팅 기능에 붙은 옵션이 아니라, 작업을 수행하는 별도 흐름(계획/실행/검증)으로 자리잡는 중이에요. 이게 들어오면 코드리뷰, 브랜치 전략, 테스트 정책까지 같이 바뀌는 경우가 많아요.

공통점 4. CLI 에이전트가 다시 뜬다(자동화 파이프라인과 궁합)

CLI 기반 코딩 에이전트는 서버/CI 환경에 붙이기 쉬워서 “반복 작업 자동화”에 강점이 있어요. 개발팀 도입 기준을 잡을 때, IDE 도구만 보지 말고 CLI 라인도 같이 비교해보는 게 좋아요.

공통점 5. 거버넌스(권한/감사/정책)가 제품 경쟁력이 된다

에이전트가 할 수 있는 일이 커질수록 “무엇을 못 하게 할지”가 더 중요해져요. 특히 엔터프라이즈는 감사 로그나 권한 설계 같은 거버넌스 기능이 사실상 도입의 출발점이 돼요.

- 관련 링크: Playcode “Best AI Coding Agents 2026”(에이전트 범주를 넓게 훑기 좋아요).

이 5가지를 기준으로 잡으면, ‘도구 이름’보다 ‘팀에 맞는 방식’을 고르는 비교가 가능해져요. - Claude Code: Advanced reasoning and large context windows for complex projects

- Codex CLI: OpenAI’s lightweight terminal agent with direct GPT access

- Gemini CLI: Fast, multimodal assistance with Google’s AI models

- OpenCode: Provider-agnostic with 75+ LLM support and LSP integration

- Aider: Git-native workflows with automatic commits and multi-file coordination

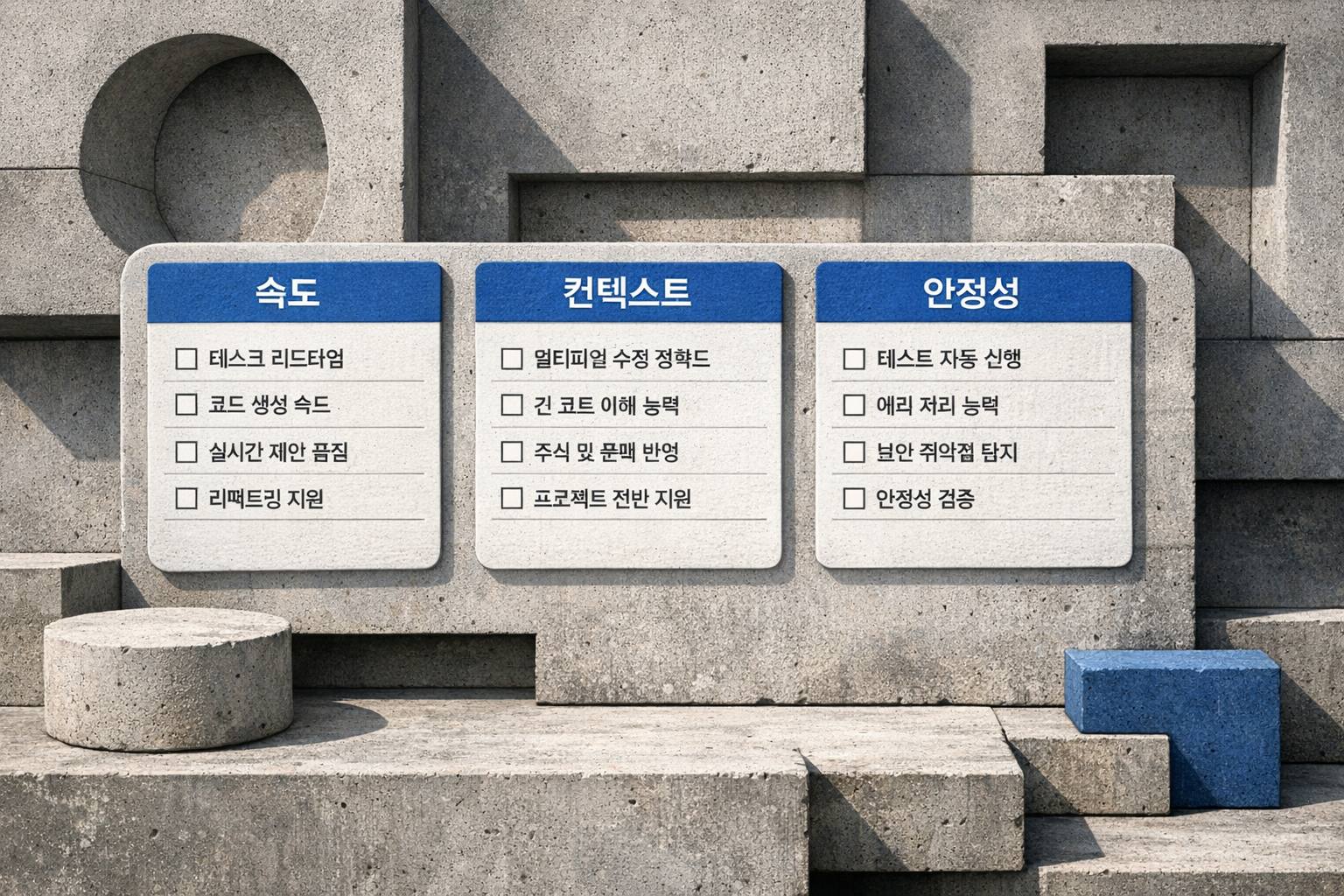

3) 비교 기준 3가지: 속도 / 컨텍스트 / 안정성(실제 평가 방법)

“개발팀 도입 기준”을 세울 때는 스펙표보다 평가 시나리오가 중요해요. 저는 아래 3가지를 숫자로 남기고, 마지막에 개발자 체감 점수를 붙이는 방식이 가장 깔끔하더라고요.

속도: 응답 속도 말고 ‘리드타임’을 재요

에이전트형은 특히 “첫 답변이 빠르냐”보다 “작업이 끝나기까지 몇 분 걸리냐”가 본질이에요. 같은 기능이라도 파일을 여러 개 건드리면 시간이 늘어나는 게 정상이라, 비교는 반드시 동일한 태스크로 해야 공정해요.

- 추천 측정: (1) 간단 수정 3개 (2) 멀티파일 리팩토링 2개 (3) 테스트 추가 2개를 돌려서 평균 리드타임을 봐요.

컨텍스트: 많이 읽는 것보다 ‘제대로 읽는지’를 봐요

리포 컨텍스트를 지원한다고 해도, 실제로는 엉뚱한 파일을 고치거나 레이어를 무시하는 경우가 있어요. 그래서 “최근 변경된 모듈과 연관된 버그” 같은 태스크를 하나 넣으면 품질 차이가 잘 드러나요.

- 추천 질문: “이 에러는 어느 레이어 문제 같아요?” “왜 이 파일을 수정했어요?” (설명 가능한지 체크해요)

안정성: 실패했을 때 복구 비용이 낮아야 해요

에이전트는 실패할 수 있어요. 중요한 건 실패했을 때 사람이 얼마나 빨리 통제할 수 있느냐예요.

- 추천 체크: 변경이 PR 단위로 묶이는지, 테스트를 자동 실행하는지, 재시도 루프가 있는지

- 관련 링크: Seedium “AI Coding Assistants Comparison” (비교 관점 잡을 때 참고하기 좋아요).

이 기준으로 평가하면 “데모는 멋진데 실전에서 불안한 도구”를 초기에 걸러낼 수 있어요. - https://seedium.io/blog/comparison-of-best-ai-coding-assistants/

4) 팀 도입 시 위험: 권한(보안) / 비용(예산) / 프로세스(리뷰)

코딩 에이전트는 도입이 쉬워 보이지만, 팀 단위로 굴리면 리스크가 바로 드러나요. 특히 에이전트형은 “코드를 쓰는 도구”가 아니라 “코드를 바꾸는 주체”가 하나 늘어나는 거라서요.

권한 리스크: 최소 권한이 기본값이어야 해요

제가 추천하는 출발점은 단순해요: 읽기 권한으로 시작하고, 쓰기 권한은 PR로만 열고, 실행 권한(빌드/테스트)은 CI에서만 허용하는 식으로 단계적으로 열어가는 거예요. 엔터프라이즈 쪽 도구들이 거버넌스를 강조하는 것도 같은 맥락이고요.

- 체크포인트: 비밀키/환경변수 접근, 외부 네트워크 호출, 패키지 설치(공급망), 배포 파이프라인 트리거

비용 리스크: “좌석 단가”보다 “사용 패턴”이 커요

구독 요금만 보면 싸 보여도, 실제로는 호출량·모델 등급·동시 사용 방식에 따라 비용이 확 튈 수 있어요. PoC에서 최소한 “개발자 1인당 주간 사용량”과 “에이전트가 만든 PR당 리뷰 시간”을 같이 재보면 예산 논쟁이 줄어들어요.

프로세스 리스크: 리뷰 기준이 바뀌어요

에이전트가 만든 코드는 사람이 만든 코드보다 “그럴듯한데 위험한” 형태로 들어오는 경우가 있어요. 그래서 리뷰 가이드도 바뀌어야 해요: 동작 확인(테스트)과 변경 범위 확인(영향도)을 우선으로 두는 방식이요.

- 관련 링크: Cloudelligent “Top AI Coding Agents 2026” (엔터프라이즈 관점 체크에 도움 돼요).

리스크를 미리 설계해두면, 도입 후에 “막아야 할 걸 뒤늦게 막는 상황”을 피할 수 있어요. - https://cloudelligent.com/blog/top-ai-coding-agents-2026/

5) 추천 시나리오(스타트업/엔터프라이즈) + 30일 PoC 플랜

도구 추천은 항상 “팀 상황”이 먼저예요. 저는 아래처럼 나눠서 접근하는 걸 좋아해요.

스타트업: 속도 우선, 대신 통제는 단순하게

- 추천 방식: 자동완성형 + 에이전트형을 같이 쓰되, 에이전트는 PR로만 들어오게 고정해요.

- 추천 태스크: 기능 개발의 막판(테스트 추가, 문서화, 리팩토링)처럼 시간을 많이 잡아먹는 구간에 먼저 붙여요.

- 팀 룰: “에이전트 PR은 최소 1명 승인” 같은 단순 룰 하나만으로도 체감 안정성이 올라가요.

엔터프라이즈: 거버넌스 우선, 확장은 단계적으로

- 추천 방식: 권한/감사/정책이 되는 환경에서 시작하고, 성공 패턴을 만든 뒤에 팀을 넓혀요.

- 추천 태스크: 내부 툴, 백오피스, 낮은 위험의 레거시 개선부터 시작해요.

- 팀 룰: 온보딩 문서(금지 작업, 허용 범위, PR 규칙)를 표준화해요.

30일 PoC 플랜(제가 자주 쓰는 구성)

1주차: 정의

- 성공 기준 2개만 정해요(예: 리드타임 20% 단축, 리뷰 수정 요청 10% 감소).

- 비교 후보를 3개로 제한해요(너무 많으면 결론이 안 나요).

2주차: 파일럿

- 동일 태스크 세트를 준비해요(간단 수정/멀티파일/테스트 추가).

- 권한은 최소로 시작해요(읽기→PR 쓰기→실행 순서).

3주차: 운영

- 주간 단위로 “PR 수, 롤백 수, 리뷰 시간”을 기록해요.

- 개발자 만족도는 짧게(좋았던 점 1, 불편한 점 1)만 받아요.

4주차: 결정

- 속도/컨텍스트/안정성 점수 + 리스크(권한/비용) 점검표로 최종 선택해요.

- 다음 단계(전사/팀별/업무별)를 명확히 정하고 끝내요.

- 관련 링크: Pinggy “Top CLI coding agents in 2026” (CLI 에이전트 라인을 볼 때 좋아요).

PoC는 길게 끌수록 조직 피로도만 쌓이니, 30일 안에 결론을 내는 게 제일 효율적이에요. - https://pinggy.io/blog/top_cli_based_ai_coding_agents/

#코딩에이전트 #AI개발도구트렌드 #코딩에이전트비교 #에이전트모드란 #개발팀도입기준 #PoC #개발생산성 #코드리뷰 #보안권한 #엔터프라이즈도입

'IT프리랜서' 카테고리의 다른 글

| 바이브 코딩(Vibe Coding)이란? 코딩 몰라도 앱 만드는 법 (2026년 최신) (0) | 2026.02.04 |

|---|---|

| Claude Code CLI 설치부터 실무 활용까지: 터미널 AI 에이전트 완벽 가이드 (0) | 2026.02.03 |

| 2026년 이미지 생성 AI 끝장 비교: GPT Image vs Midjourney vs 나노바나나 끝장 분석 (0) | 2026.01.29 |

| 무료 AI 툴 추천 2026|ChatGPT 대체부터 업무 자동화까지 완전 무료 생성형 AI 쓰는 법 (1) | 2026.01.28 |

| 피지컬 AI 로봇 한국 시장 비교 리뷰(2026) | SKT vs NVIDIA·CES 트렌드·AMR 파이썬 실습까지 (0) | 2026.01.28 |